I / Le son, comme variation de pression ou comme une onde.

-

corderaide

- Il est frais mon topic !

- Messages : 11198

- Inscription : 24 déc. 2012 00:05

- Contact :

Re: I / Le son, comme variation de pression ou comme une ond

Et le premier pavé est arrivé \o/

Il est infiniment plus rapide d'énoncer une connerie que de la réfuter.

- jecr

- Tombeau-Blaster

- Messages : 4104

- Inscription : 27 avr. 2012 09:34

- Localisation : Collines de Marcel Pagnol

- Contact :

OK, je comprends, le staff TN ils t'ont passé testeur pour te motiver à pondre tout ça en fait.

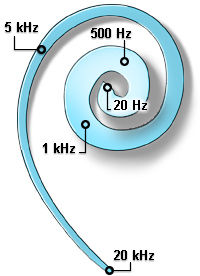

Et tu vas aller jusqu'à expliquer la transformée de Fourier pour comprendre comment dans une seule onde tu peux avoir toute les fréquences et donc le son de ta voiture et de ton orgue en même temps, et le boulot de décodage fait par le cerveau?

Et tu vas aller jusqu'à expliquer la transformée de Fourier pour comprendre comment dans une seule onde tu peux avoir toute les fréquences et donc le son de ta voiture et de ton orgue en même temps, et le boulot de décodage fait par le cerveau?

Du bon son avec iPhone + Sony WF-1000xm4

iPod Classic 160Go - LOD - Vorzamp Duo - CA H8P / ES SEM9

Light/Maison : iPod Classic + Pico Slim + SA7 ou Listen

Sport : Sansa Clip Zip + SA7 ou CAA

Voiture : iPod Touch + Griffin Tuneflex AUX

Mon matos:

Light/Maison : iPod Classic + Pico Slim + SA7 ou Listen

Sport : Sansa Clip Zip + SA7 ou CAA

Voiture : iPod Touch + Griffin Tuneflex AUX

Mon matos:

Je te soutiens castle.

- castleofargh

- J'ai des câbles en or massif

- Messages : 2780

- Inscription : 27 sept. 2012 06:22

- Contact :

Non c'est une magouille pour devenir général du monde (encore). le truc c'est que j'ai besoin de faire accepter l'expression de pression au court du temps pour parler du numérique vu que tout derrière est en db. Donc en rabachant un peu ici avec la base de base, j’espère aider à faire passer le reste plus tard.jecr a écrit :OK, je comprends, le staff TN ils t'ont passé testeur pour te motiver à pondre tout ça en fait.

Et tu vas aller jusqu'à expliquer la transformée de Fourier pour comprendre comment dans une seule onde tu peux avoir toute les fréquences et donc le son de ta voiture et de ton orgue en même temps, et le boulot de décodage fait par le cerveau?

La finalité étant de comprendre le PCM pour comprendre comment + ne veut pas forcément dire mieux. Mais évidement je reste théorique et simple(trop), donc il y a toujours matière à contester mes conclusions.

Mais cette fois j'ai voulu faire quelque chose d'accessible. Le temps dira si j'ai fail.

Castle : you are my hero kitty.

J'aime ces articles où à la fin on se sent moins con.

H.

J'aime ces articles où à la fin on se sent moins con.

H.

-

Kooka

Ou "plus con", si on a rien capté ...herm2s a écrit :J'aime ces articles où à la fin on se sent moins con.

-

corderaide

- Il est frais mon topic !

- Messages : 11198

- Inscription : 24 déc. 2012 00:05

- Contact :

Il est infiniment plus rapide d'énoncer une connerie que de la réfuter.

- DarkZunicorn

- Audio spammeur en force

- Messages : 19498

- Inscription : 01 sept. 2011 13:29

- Contact :

Excellent, tout simplement excellent, castle!

J'attends la suite avec impatience.

Maintenant, la remarque de jecr sur la nécessite d'évoquer quand même le "décodage" effectué par le cerveau me semble tout à fait pertinente car ce décodage fait appel à la capacité de percevoir la cohérence d'un son (ce qui fait, par exemple, qu'on finit par reconnaître puis suivre l'évolution dans le temps d'une onde particulière ou d'une composition d'ondes particulière dans un apparent "chaos" sonore, au-dessus du bruit) or cette capacité repose sur tout un apprentissage, une éducation, une culture de l'audition... (ce qui vaut aussi pour les autre sens)

J'attends la suite avec impatience.

Maintenant, la remarque de jecr sur la nécessite d'évoquer quand même le "décodage" effectué par le cerveau me semble tout à fait pertinente car ce décodage fait appel à la capacité de percevoir la cohérence d'un son (ce qui fait, par exemple, qu'on finit par reconnaître puis suivre l'évolution dans le temps d'une onde particulière ou d'une composition d'ondes particulière dans un apparent "chaos" sonore, au-dessus du bruit) or cette capacité repose sur tout un apprentissage, une éducation, une culture de l'audition... (ce qui vaut aussi pour les autre sens)

Tanchjim Space → Raptgo Hook-X avec Lunashops LN008426 et Azla Sedna Crystal

Tanchjim Luna → TinHIFI P1 Max II Giant Panda avec IvipQ 539 et SpinFit W1

FiiO KA17 → Shozy P20 avec Lunashops LN008523 et FiiO HS18

F.Audio DS02 → FiiO FT1 avec câble et bonnettes d'origine

Pioneer U-05-S → Geshelli Erish → Fostex TH-610 avec Lunashops LN008324 XLR4 et bonnettes d'origine

Tanchjim Luna → TinHIFI P1 Max II Giant Panda avec IvipQ 539 et SpinFit W1

FiiO KA17 → Shozy P20 avec Lunashops LN008523 et FiiO HS18

F.Audio DS02 → FiiO FT1 avec câble et bonnettes d'origine

Pioneer U-05-S → Geshelli Erish → Fostex TH-610 avec Lunashops LN008324 XLR4 et bonnettes d'origine

-

corderaide

- Il est frais mon topic !

- Messages : 11198

- Inscription : 24 déc. 2012 00:05

- Contact :

J'peux tenter un rapide cours sur la transformée de Fourrier (et celle effectuée par notre cerveau), mais je suis pas non plus un expert...DarkZenith a écrit :Excellent, tout simplement excellent, castle!

J'attends la suite avec impatience.

Maintenant, la remarque de jecr sur la nécessite d'évoquer quand même le "décodage" effectué par le cerveau me semble tout à fait pertinente car ce décodage fait appel à la capacité de percevoir la cohérence d'un son (ce qui fait, par exemple, qu'on finit par reconnaître puis suivre l'évolution dans le temps d'une onde particulière ou d'une composition d'ondes particulière dans un apparent "chaos" sonore, au-dessus du bruit) or cette capacité repose sur tout un apprentissage, une éducation, une culture de l'audition... (ce qui vaut aussi pour les autre sens)

Bref, comment notre cerveau interprète le son ?

Il est infiniment plus rapide d'énoncer une connerie que de la réfuter.

- castleofargh

- J'ai des câbles en or massif

- Messages : 2780

- Inscription : 27 sept. 2012 06:22

- Contact :

mon point de vue sur la question cerveau c'est que l’expérience "vie de tous les jours" sert de calibration.

si quelqu'un entend un poulpe qui pète quand le son d'un violon passe dans son oreille(pas de bol pour lui), il va s'habituer au fait que c'est le son d'un violon, et aussi apprendre à faire la différence entre un bon poulpe et un mauvais poulpe.

ce qui compte c'est de bien savoir remettre le bon son devant le tympan, le reste c'est au cerveau de jouer de sa plasticité légendaire pour calibrer le bordel.

de la même façon qu'on ne va pas changer la valeur d'un gris pour une personne qui regarde une image parce qu'il a moins de bâtonnets qui captent le rouge. c'est son cerveau "et" son éducation qui vont lui faire apprendre ce qu'est un gris 204 204 204. il ne le verra peut etre jamais gris, mais il saura que c'est gris parce que tout le monde lui aura dit.

en audio on devrait faire ça egalement et arreter d'inventer 25 signatures de neutre pour que chacun puisse se toucher en pretendant aimer le son neutre. ce que l'on entend est potentielement unique à chaque personne de toute façon. alors autant que tout le monde parle d'un seul neutre. c'est juste du vocabulaire, et ça ne change pas ce que l'on entend vraiment(tant que l'on n'ajoute pas l'idée que celui qui n'aime pas le neutre est un con, psycho acoustique powa).

mais ça par contre ça reste mon point de vue, c'est assez compliquer à justifier scientifiquement. donc je ne me vois pas trop en faire un article ^_^.

si quelqu'un entend un poulpe qui pète quand le son d'un violon passe dans son oreille(pas de bol pour lui), il va s'habituer au fait que c'est le son d'un violon, et aussi apprendre à faire la différence entre un bon poulpe et un mauvais poulpe.

ce qui compte c'est de bien savoir remettre le bon son devant le tympan, le reste c'est au cerveau de jouer de sa plasticité légendaire pour calibrer le bordel.

de la même façon qu'on ne va pas changer la valeur d'un gris pour une personne qui regarde une image parce qu'il a moins de bâtonnets qui captent le rouge. c'est son cerveau "et" son éducation qui vont lui faire apprendre ce qu'est un gris 204 204 204. il ne le verra peut etre jamais gris, mais il saura que c'est gris parce que tout le monde lui aura dit.

en audio on devrait faire ça egalement et arreter d'inventer 25 signatures de neutre pour que chacun puisse se toucher en pretendant aimer le son neutre. ce que l'on entend est potentielement unique à chaque personne de toute façon. alors autant que tout le monde parle d'un seul neutre. c'est juste du vocabulaire, et ça ne change pas ce que l'on entend vraiment(tant que l'on n'ajoute pas l'idée que celui qui n'aime pas le neutre est un con, psycho acoustique powa).

mais ça par contre ça reste mon point de vue, c'est assez compliquer à justifier scientifiquement. donc je ne me vois pas trop en faire un article ^_^.

- jecr

- Tombeau-Blaster

- Messages : 4104

- Inscription : 27 avr. 2012 09:34

- Localisation : Collines de Marcel Pagnol

- Contact :

Pas mal expliqué du tout Corde.

J'ai effectivement toujours pensé le cerveau comme un ADC (un anti-DAC quoi...). Y en a forcément des bons et des moins bons, des plutôt froids ou des plutôt analytiques. Donc on n'entend pas forcément un même son de la même façon.

Le cerveau a aussi la capacité à se concentrer sur une partie des informations qui lui arrivent.

De la même façon qu'on a un champ de vision à près de 180°, mais qu'on ne voit clairement que les 10° sur lesquels on se concentre (et vers lesquels les yeux pointent... bon OK mauvais exemple, ya aussi la directivité du capteur en ce qui concerne l’œil). Donc en plus de la calibration sur des sons connus qui vont influer sur la perception dans son référentiel construit au fur et a mesure, il y a aussi un espèce d'égaliseur interne qui permet de faire remonter une bande de fréquence si on se concentre dessus.

J'ai effectivement toujours pensé le cerveau comme un ADC (un anti-DAC quoi...). Y en a forcément des bons et des moins bons, des plutôt froids ou des plutôt analytiques. Donc on n'entend pas forcément un même son de la même façon.

Le cerveau a aussi la capacité à se concentrer sur une partie des informations qui lui arrivent.

De la même façon qu'on a un champ de vision à près de 180°, mais qu'on ne voit clairement que les 10° sur lesquels on se concentre (et vers lesquels les yeux pointent... bon OK mauvais exemple, ya aussi la directivité du capteur en ce qui concerne l’œil). Donc en plus de la calibration sur des sons connus qui vont influer sur la perception dans son référentiel construit au fur et a mesure, il y a aussi un espèce d'égaliseur interne qui permet de faire remonter une bande de fréquence si on se concentre dessus.

Dernière modification par jecr le 09 mai 2014 00:39, modifié 1 fois.

Du bon son avec iPhone + Sony WF-1000xm4

iPod Classic 160Go - LOD - Vorzamp Duo - CA H8P / ES SEM9

Light/Maison : iPod Classic + Pico Slim + SA7 ou Listen

Sport : Sansa Clip Zip + SA7 ou CAA

Voiture : iPod Touch + Griffin Tuneflex AUX

Mon matos:

Light/Maison : iPod Classic + Pico Slim + SA7 ou Listen

Sport : Sansa Clip Zip + SA7 ou CAA

Voiture : iPod Touch + Griffin Tuneflex AUX

Mon matos:

-

corderaide

- Il est frais mon topic !

- Messages : 11198

- Inscription : 24 déc. 2012 00:05

- Contact :

Tu confonds encore deux choses castle : ce qui est mesuré (les graphes de fréquence d'un signal, que ça soit le cerveau ou un micro+traitement derrière) et ce qui est interprété (tiens, y'a plus de basses, tiens le soundstage est plus vaste dans le cas de mesures sur un casque ou pour le cerveau : tiens, ce poulpe qui pète on m'a dit que c'était du violon donc c'est du violon.).

Ce qui est mesuré est en effet là, présent, absolu. Ce qu'une oreille mesure, un instrument de mesure saura le mesurer. Par contre, ce qu'un cerveau interprète ne sera pas toujours interprété par des algo. (Une courbe de fréquence sera interprétée par des algo de FFT, ou de la disto de signal, par contre la largeur d'une scène je demande encore à voir une mesure de cette dernière... Et quand je dis mesure, c'est d'une interprétation quantitative dont je parle.)

Là où le cerveau évolue, s'éduque, c'est dans l'interpération. Tu peux avoir la meilleure éducation du monde, si un signal est à 30kHz et que t'as aucun cil qui vibre (il me semble que les cils vibrent plus après dans le meilleur des cas 22 ou 23kHz mais je demande vérification) bah ton cerveau recevra rien.

Si en revanche ton cerveau reçoit un signal mais qu'il est trop faible pour être analysé, avec de l'entraînement p't'être que ton cerveau arrivera à comprendre ce que c'est. Ou peut-être pas, nos capacités étant limitées.

Dans les tests ABX, le seul truc que ça montre, c'est qu'un ensemble de cerveaux n'arrive pas à interpréter de différence entre deux signaux (à l'aune de l'éducation de l'oreille de chacun), et on essaye de prendre cet ensemble le plus large possible pour valider le fait qu'aucune "oreille" (dans le sens oreille + cerveau) n'entend de différence.

En fait, on devrait plus parler d'éducation du cerveau que d'éducation de l'oreille : l'oreille, elle prends un son et renvoie un signal électrique, et avec tout l'entraînement du monde elle bouge pas, le cerveau lui évolue selon les besoins (la plasticité du cerveau).

@Jecr : l'égaliseur est inclus en partie dans ton oreille avant la cochlée, après ce que tu nommes focalisation, c'est a priori ton cerveau qui a la répartition en fréquence devant lui et qui zoome sur une partie du signal (pas forcément connexe), en gros qui se focalise sur un des signaux-terme du grand signal qui est la somme de ces petits signaux. (pas ultra clair... je vais aller dormir avant de raconter des clowneries)

Ce qui est mesuré est en effet là, présent, absolu. Ce qu'une oreille mesure, un instrument de mesure saura le mesurer. Par contre, ce qu'un cerveau interprète ne sera pas toujours interprété par des algo. (Une courbe de fréquence sera interprétée par des algo de FFT, ou de la disto de signal, par contre la largeur d'une scène je demande encore à voir une mesure de cette dernière... Et quand je dis mesure, c'est d'une interprétation quantitative dont je parle.)

Là où le cerveau évolue, s'éduque, c'est dans l'interpération. Tu peux avoir la meilleure éducation du monde, si un signal est à 30kHz et que t'as aucun cil qui vibre (il me semble que les cils vibrent plus après dans le meilleur des cas 22 ou 23kHz mais je demande vérification) bah ton cerveau recevra rien.

Si en revanche ton cerveau reçoit un signal mais qu'il est trop faible pour être analysé, avec de l'entraînement p't'être que ton cerveau arrivera à comprendre ce que c'est. Ou peut-être pas, nos capacités étant limitées.

Dans les tests ABX, le seul truc que ça montre, c'est qu'un ensemble de cerveaux n'arrive pas à interpréter de différence entre deux signaux (à l'aune de l'éducation de l'oreille de chacun), et on essaye de prendre cet ensemble le plus large possible pour valider le fait qu'aucune "oreille" (dans le sens oreille + cerveau) n'entend de différence.

En fait, on devrait plus parler d'éducation du cerveau que d'éducation de l'oreille : l'oreille, elle prends un son et renvoie un signal électrique, et avec tout l'entraînement du monde elle bouge pas, le cerveau lui évolue selon les besoins (la plasticité du cerveau).

@Jecr : l'égaliseur est inclus en partie dans ton oreille avant la cochlée, après ce que tu nommes focalisation, c'est a priori ton cerveau qui a la répartition en fréquence devant lui et qui zoome sur une partie du signal (pas forcément connexe), en gros qui se focalise sur un des signaux-terme du grand signal qui est la somme de ces petits signaux. (pas ultra clair... je vais aller dormir avant de raconter des clowneries)

Il est infiniment plus rapide d'énoncer une connerie que de la réfuter.

- jecr

- Tombeau-Blaster

- Messages : 4104

- Inscription : 27 avr. 2012 09:34

- Localisation : Collines de Marcel Pagnol

- Contact :

Pour la focalisation c'est le cerveau effectivement, je crois pas avoir dit le contraire ou alors je me suis pas exprimé. L'égaliseur interne que je vois dans le cerveau, c'est un égaliseur variable en fonction de ce qu'on lui demande.corderaide a écrit :@Jecr : l'égaliseur est inclus en partie dans ton oreille avant la cochlée, après ce que tu nommes focalisation, c'est a priori ton cerveau qui a la répartition en fréquence devant lui et qui zoome sur une partie du signal (pas forcément connexe), en gros qui se focalise sur un des signaux-terme du grand signal qui est la somme de ces petits signaux. (pas ultra clair... je vais aller dormir avant de raconter des clowneries)

Par contre effectivement j'avais pas pensé à l'oreille, qui est un égaliseur fixe, ou plutôt la partie composants de l'anti-DAC, et qui va donc induire sa signature sonore.

Du bon son avec iPhone + Sony WF-1000xm4

iPod Classic 160Go - LOD - Vorzamp Duo - CA H8P / ES SEM9

Light/Maison : iPod Classic + Pico Slim + SA7 ou Listen

Sport : Sansa Clip Zip + SA7 ou CAA

Voiture : iPod Touch + Griffin Tuneflex AUX

Mon matos:

Light/Maison : iPod Classic + Pico Slim + SA7 ou Listen

Sport : Sansa Clip Zip + SA7 ou CAA

Voiture : iPod Touch + Griffin Tuneflex AUX

Mon matos:

- castleofargh

- J'ai des câbles en or massif

- Messages : 2780

- Inscription : 27 sept. 2012 06:22

- Contact :

Je ne mélange rien du tout, tu décides de lire mon post de travers(et en l’occurrence tu tentes de m'expliquer que je mélange 2 choses en me parlant de 15trucs en même temps, dont pas mal qui ne sont pas dans ce post . Je ne sais pas si c'est la bonne pédagogie ^_^).corderaide a écrit :Tu confonds encore deux choses castle : ce qui est mesuré (les graphes de fréquence d'un signal, que ça soit le cerveau ou un micro+traitement derrière) et ce qui est interprété (tiens, y'a plus de basses, tiens le soundstage est plus vaste dans le cas de mesures sur un casque ou pour le cerveau : tiens, ce poulpe qui pète on m'a dit que c'était du violon donc c'est du violon.).

Ce qui est mesuré est en effet là, présent, absolu. Ce qu'une oreille mesure, un instrument de mesure saura le mesurer. Par contre, ce qu'un cerveau interprète ne sera pas toujours interprété par des algo. (Une courbe de fréquence sera interprétée par des algo de FFT, ou de la disto de signal, par contre la largeur d'une scène je demande encore à voir une mesure de cette dernière... Et quand je dis mesure, c'est d'une interprétation quantitative dont je parle.)

Là où le cerveau évolue, s'éduque, c'est dans l'interpération. Tu peux avoir la meilleure éducation du monde, si un signal est à 30kHz et que t'as aucun cil qui vibre (il me semble que les cils vibrent plus après dans le meilleur des cas 22 ou 23kHz mais je demande vérification) bah ton cerveau recevra rien.

Si en revanche ton cerveau reçoit un signal mais qu'il est trop faible pour être analysé, avec de l'entraînement p't'être que ton cerveau arrivera à comprendre ce que c'est. Ou peut-être pas, nos capacités étant limitées.

Dans les tests ABX, le seul truc que ça montre, c'est qu'un ensemble de cerveaux n'arrive pas à interpréter de différence entre deux signaux (à l'aune de l'éducation de l'oreille de chacun), et on essaye de prendre cet ensemble le plus large possible pour valider le fait qu'aucune "oreille" (dans le sens oreille + cerveau) n'entend de différence.

En fait, on devrait plus parler d'éducation du cerveau que d'éducation de l'oreille : l'oreille, elle prends un son et renvoie un signal électrique, et avec tout l'entraînement du monde elle bouge pas, le cerveau lui évolue selon les besoins (la plasticité du cerveau).

@Jecr : l'égaliseur est inclus en partie dans ton oreille avant la cochlée, après ce que tu nommes focalisation, c'est a priori ton cerveau qui a la répartition en fréquence devant lui et qui zoome sur une partie du signal (pas forcément connexe), en gros qui se focalise sur un des signaux-terme du grand signal qui est la somme de ces petits signaux. (pas ultra clair... je vais aller dormir avant de raconter des clowneries)

Ce que je dis c'est que la façon dont chacun va percevoir réellement le son ne devrait pas servir d'excuse pour foutre en l'air des valeurs références.

Comme pour la couleur, un daltonien ne vient pas casser les couilles en disant qu'un truc d'une couleur est gris.

Comme personne ne vient dire qu'un 500hz il l'entend plutôt comme un 400hz. Ou qu'un billet de 50euro n'est qu'un de 20.

Le fait qu'une oreille soit différente d'une autre, qu'une oreille interne ait plus de cils ou qu'un cerveau malade décide d'entendre des poulpes. Tout cela ne devrait pas changer ce que l'on appelle neutre. Ou ce qui est une basse correcte.

-Pourquoi je parle de calibration du cerveau :

Quand une chaîne hifi et des enceintes sonnent neutre (celui qui a été défini par les instruments cette fois), il se trouve que de manière statistique les gens préfèrent cette signature à d'autres signatures.

D'un côté on a les gens qui revendiquent une individualité d'oreille et d’écoute avec tous les arguments, de la science, de la psycho, et de l’âme, qui peuvent aller dans ce sens. et de l'autre côté les tests sur enceintes montrent que grosso modo les gens aiment majoritairement le même genre de signature.

Dans le même temps olive et welti ont montré exactement la même chose avec les casques l'année dernière.

Les gens à qui ils demandaient de régler un casque neutre arrivaient globalement à la même chose, et les gens à qui ils demandaient de choisir le son qu'ils préféraient, préféraient majoritairement le même son.

Donc si ces tests sont bons et significatifs(ce que je pense), alors il y a 2 options :

1/ on n'entendrait pas si différemment qu'on veut bien nous le faire croire.

2/ notre cerveau est capable de calibrer correctement le système « homme », grâce aux indices de la vie de tous les jours.

Ta question sur le soundstage n'a rien à voir, j'y ai déjà répondu sur l'autre topic …

en ayant une largeur de crane différente, les décalages de timing qui vont bien marcher pour une petite tête, vont forcément donner autre chose pour une tête plus grosse. C'est de la géométrie toute conne.

Une certaine signature est nécessaire(ou au moins importante) pour avoir le maximum d'un effet de placement dans l'espace. On est donc en droit de penser qu'un mec à qui il manque beaucoup d'aigus ne va pas bénéficier autant de certains effets 3d.

Le fait que les drivers droite et gauche soient le plus équilibrés possible va forcément aider.

La quantité de distorsion évidement va jouer, si le son est trop changer, les infos de 3D vont fatalement l’être aussi.

La qualité de séparation stéréo de chaque matos de la chaîne audio.

il y a peu de mystères là derrière, et nul besoin d'invoquer les esprits.

Pour un casque le résultat est apparemment pas super parce que l'humain incline la tête pour faire un genre de triangulation perso et se servir de ça pour certaines infos. Forcement avec un casque, zobbi l'inclinaison de tête pour l'instant (y a une boite qui bosse sur ça et un article de tyll).

Maintenant comme les femmes sont généralement moins bonnes en visualisation 3D que les hommes, est ce que je peux en conclure qu'un soundstage est moins grand ou moins fun pour une femme ? Je ne sais pas.

Et ce que je peux affirmer que le son que j’entends ne sonne pas plus large si je l’écoute dans un champ au lieu de l’écouter dans un 9m² ? Non, je n'ai pas passé les 30 dernières années à étudier le sujet avec des milliards de subvention et la psycho-acoustique fera toujours chier quoi qu'il arrive.

Mais si refais arriver au tympan les mêmes indices d’écart de volume et de timing qu'une position X dans le monde réel, alors il est probable que pour la majorité des gens, l'impression de position sera proche de celle de X.

castleofargh a écrit :Maintenant comme les femmes sont généralement moins bonnes en visualisation 3D que les hommes, est ce que je peux en conclure qu'un soundstage est moins grand ou moins fun pour une femme ? Je ne sais pas.